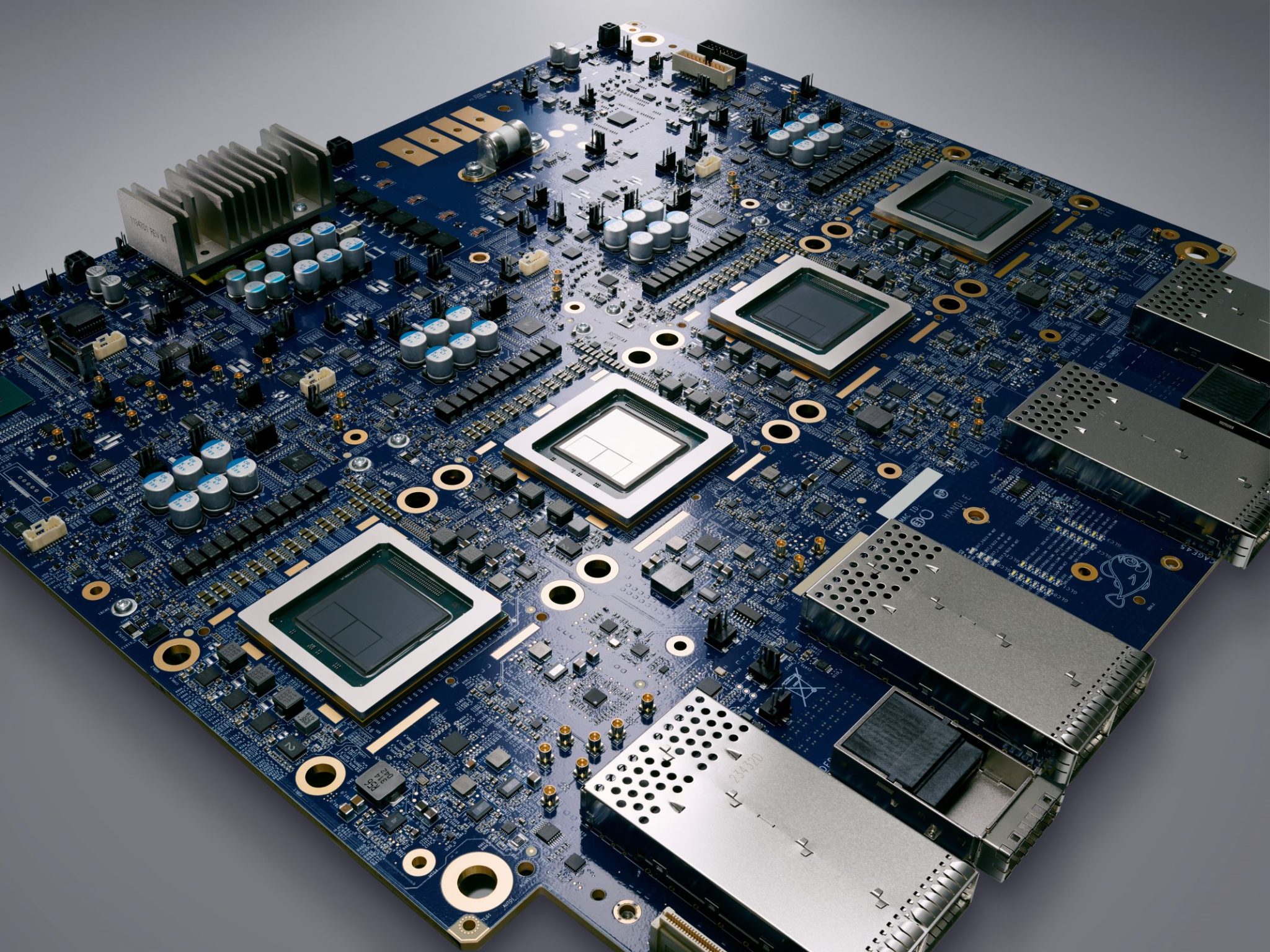

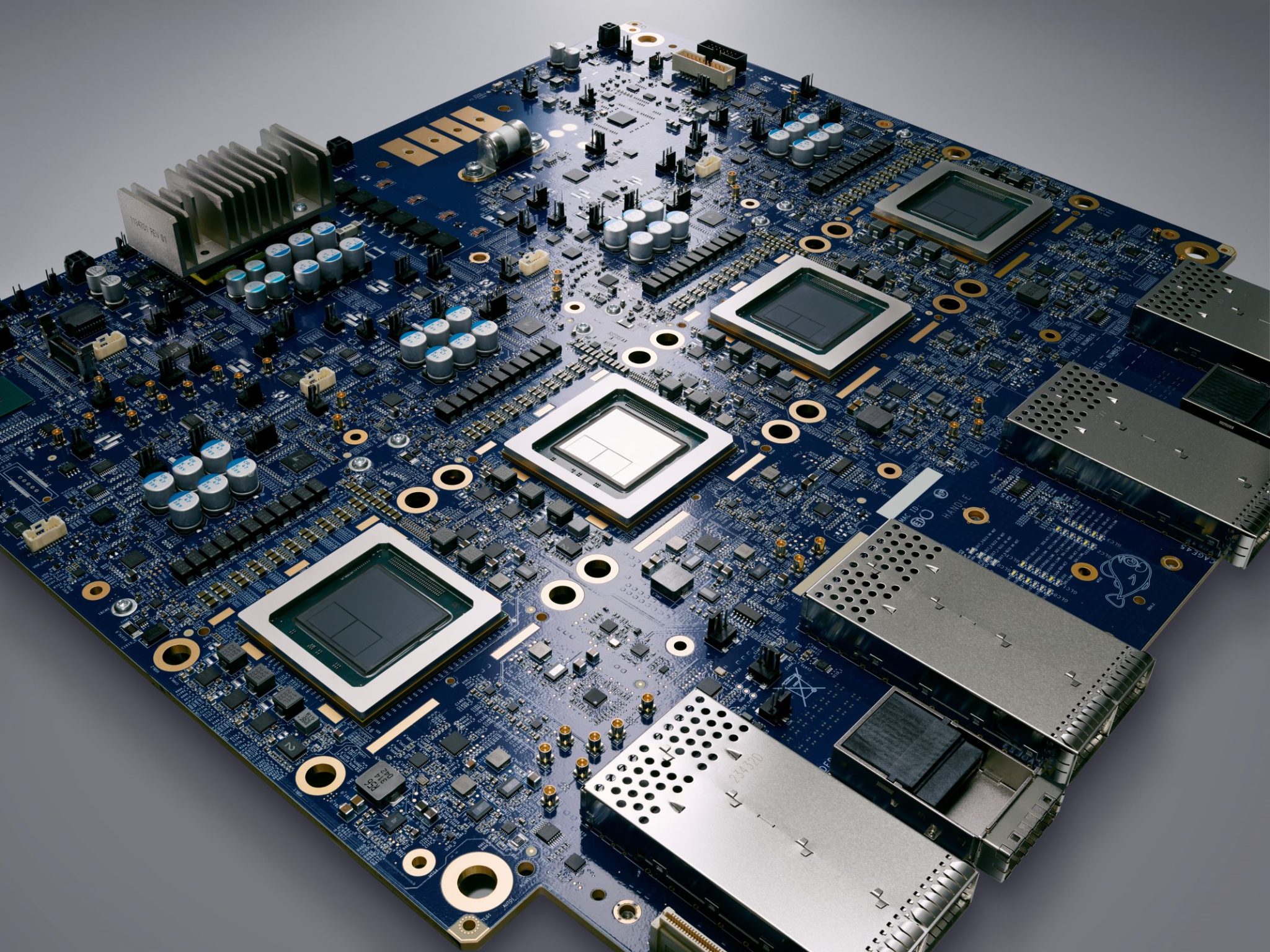

圖片來源:Google Cloud。

Google 近年持續耕耘自研晶片,去年底剛開放給所有客戶使用的 Trillium TPU,已是其最新、目前效能最強的第六代 TPU。值得關注的是,Google 就是拿 Trillium TPU 來訓練自家最新 AI 模型 Gemini 2.0 ,而 Google Cloud 在 1/15 舉辦線上媒體舉會,也再次強調自家的技術優勢。

開發整合式超級運算架構,納入 TPU、GPU、CPU

Google Cloud 表示,隨著生成式 AI 掀起創新浪潮,對運算效能的需求也與日俱增,而晶片需要的是系統、不只是硬體,因此他們進一步開發出整合式超級運算架構「AI Hypercomputer」,來整合包含 TPU、GPU 和 CPU 在內的硬體、開放軟體,以及可彈性消費的模型。

Google Cloud 產品群經理 Mohan Pichika 表示,最重要的是這些元件能結合在一起和諧工作,才能產生威力。

Trillium 作為第 6 代 TPU,厲害在哪?

針對最新的第六代 TPU ,Pichika 表示,Trillium 是專門為類神經網路設計的機器學習加速器,並且是為了專門目的而設計,不是通用目的。

相較前一代產品,Trillium 也有顯著進展:訓練效能提升超過 4 倍、推論處理量增加至 3 倍、能源效率提升 67%。在硬體規格方面,每顆晶片的尖峰效能提高 4.7 倍,高頻寬記憶體容量和晶片間互連網路頻寬都提升 1 倍。特別的是,單一 Jupiter 網路架構可同時容納和運作多達 10 萬個 Trillium 晶片。

Google 透過測試數據指出,在處理 Llama-2-70b 和 gpt3-175b 等大型語言模型時,Trillium 的訓練速度比前代 Cloud TPU v5e 快 4 倍;從成本效益來看,每美元可獲得的訓練效能提升 2.5 倍,推論效能則提升 1.4 倍。目前這款處理器已應用於訓練 Google 的 Gemini 2.0 模型,同時也支援搜尋、相簿與地圖等核心服務。

針對訓練 Gemini 2.0 這類型的大型模型需要大量的資料和運算,Google Cloud 指出 Trillium 的近線性擴充能力(near-linear scaling capabilities)能讓模型高效且精準的分配工作負載,大幅提高訓練速度。不過,Pichika 也提到,雖然目前 TPU 應用場景多在生成式 AI,但相信未來可以運用在更多創新上。